MySQL_慢SQL调优总结

MySQL 慢SQL调优总结

MySQL 慢SQL调优总结

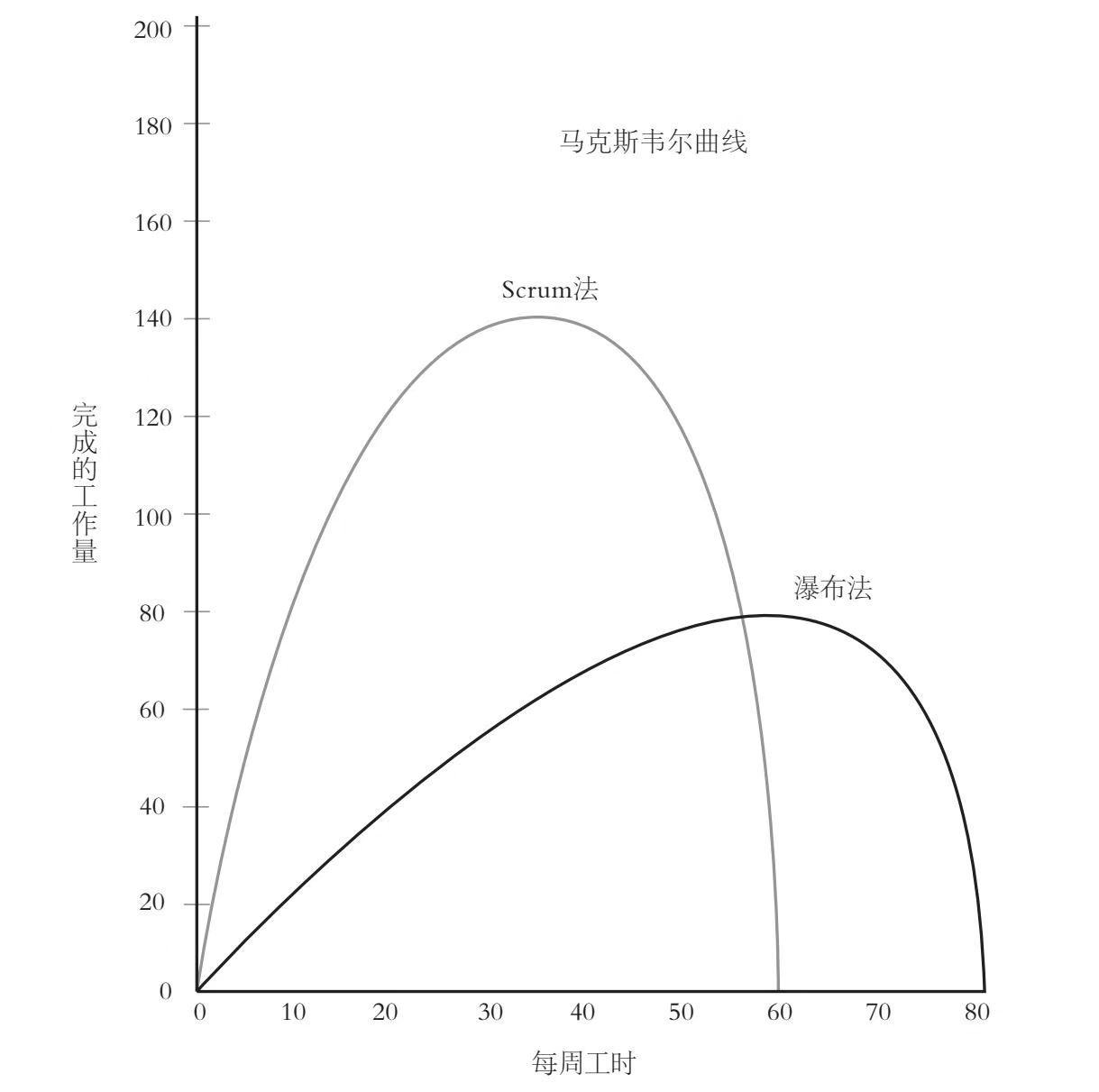

传统方法(主要是瀑布法)效率不足且经常引起项目最终无法交付。

团队效率的提升比个人能力的提升对项目完成的影响更大

卓越团队的特点:

如果你出了一个错误(我们都会出错),那就在发现错误时立即修改,不然就会付出代价。

生产流程应该是持续改进的,而处理问题的最佳时机是你发现问题的时候,而不是发现问题之后很久再着手解决。

出现问题不立即修复,而是放到很久之后,会浪费更多时间:当你在做一个项目的时候,大脑专注于它,你很清楚做某件事的所有原因,这时你的脑子里存在一个与之相关的复杂架构,想在几个星期后重新建立这样的架构十分困难,会花费更多时间。

工作时间太长的人会开始犯错,而改正错误可能会比创造新成绩花费更多的时间。工作超出负荷的员工比较不容易集中注意力,而且会影响别人也跟着分心,不久之后他们就会开始做出错误决策。

这意味着我们更应该关注完成任务的时长和质量而不是工时长短。

有几种不合理现象:

1、目标荒谬、不切实际

2、期待过高

3、负担过重,比如繁琐的规定、没必要的汇报、会议等过多

4、情绪浪费,比如团队中某个人倾向于激怒别人、削弱团队斗志。

给项目划分任务

确立优先级:由产品负责人决定优先级

确定需要花费多少精力、时间和资金。怎么知道自己的速度?每个成员冲刺周期结束时复盘可以知道自己的效率如何,并且可以通过消除障碍来变得更快

让执行团队评估自己的工作

用用户故事描绘任务:角色、活动、商业价值

用户故事必须完整:独立性、可协商性(不要带太多细节)、有价值、可评估、规模小、可测试

用户故事来源:需要产品负责人拿出一半时间与购买产品的客户开展对话(了解客户对于最新产品的看法,看看自己的产品是否为客户创造了价值),还要拿出一半时间拟定待办事项清单(让团队成员知道客户重视什么、不重视什么)。

产品负责人的特点

信息瀑布:人们倾向于遵从之前众人的行为 - 别人的评估意见只能拿来作为参考,以便改进自己的判断,而不是完全取代自己的判断。

光环效应:是指当认知者对一个人的某种特征形成好或坏的印象后,还倾向于据此推论该人其他方面的特征,本质上属于以偏概全的认知错误 - 评估时保证匿名性,减少互相影响

拥抱变化:一般最初的计划评估不会完美,关键在于,要在项目执行过程中及时加以调整和改进,而不是刻板地遵循计划。详细规划出能够创造出新价值的部分,至于项目中的剩余部分,计划粗略一些也无所谓。每个冲刺周期结束之际,都必须为顾客展示一些看得见、摸得着的新价值。你可以问顾客一些问题,比如,这是你要的吗?这能帮你解决一些问题吗?我们的方向是对的吗?如果答案是否定的,那么你就要修改你的计划。

往往20%的功能可以覆盖80%的价值

1、根据产品负责人对需求优先级的排列可以确定最重要的那部分需求

2、先做最重要的MVP部分,以期快速得到市场反馈,在此基础上检查和调整产品

Scrum的目的之一是降低项目研发过程中的风险,常见的风险是市场风险、技术风险和财务风险。

市场风险:Scrum注重渐进式迭代,每个周期通过show case将产品展示给客户,收集用户意见,因此可以实时对产品做出小改动,不必等到投入大量成本后再被迫做出改动。

技术风险:先做几种原型,实际加以比较。

财务风险:怎么发现自己做的产品能挣到钱?渐进式迭代+showcase

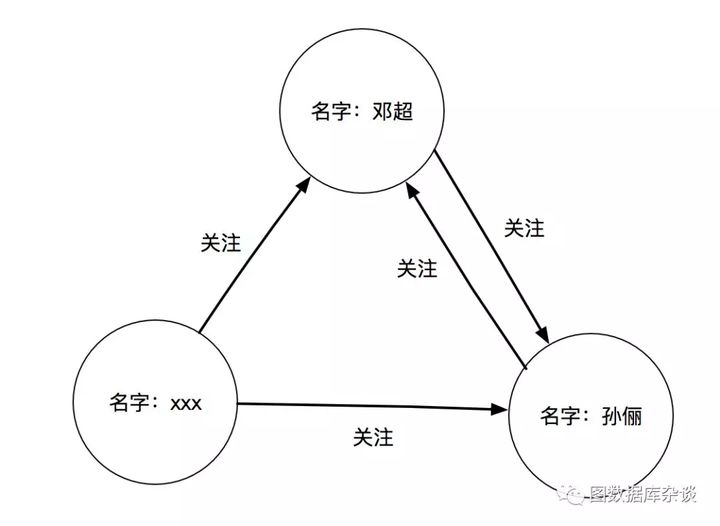

属性图结构

在节点和关联关系不是很复杂的情况下,我们建的图通常只有一个领域的内容,比如人与人之间的关联图谱。但是随着业务的发展,我们会觉得单一的人物关系不能满足我们的使用需求,我还希望加入企业注册数据,来进行企业与人之间的管理分析。随后,我们陆续加入了法律诉讼信息、新闻资讯信息等,这样我们的图从一张小图变成了大图,也从只有一个领域(人)的模型变成了多个领域的跨域模型。

跨域模型有助于我们理解复杂的价值链背后的关联,不仅可以联合多个领域,而且每个领域的内容又能单独区分开来。这里主要借助了图数据里的2个概念:属性图和标签。属性图模型让不同的领域很容易联系起来,这样每个域都是可达的;标签既能表示不同节点在域中扮演的角色,又可以让我们将它归属的节点和元数据结合起来。

建模其实就是利用图结构来描述问题的过程,为了使我们的模型更接近业务需求,有一个方法,叫做面向查询设计:

1 | # 创建带有属性name和age的People节点 |

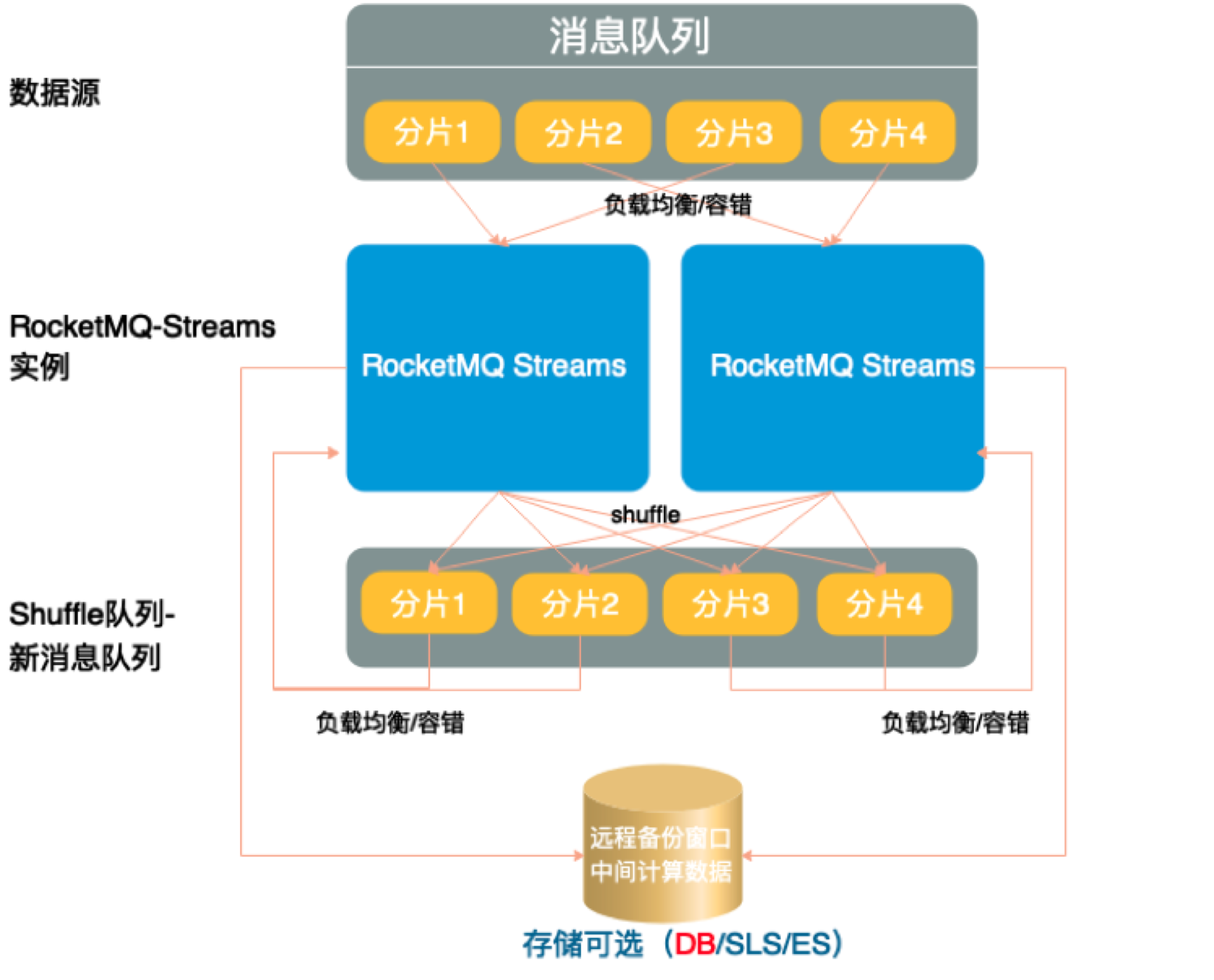

ISource消费数据源触发条件:

分类:

RocketMQSource读取来自RocketMQ的消息流程(RocketMQSource):

1.

IStreamOperator算子处理来自Source的数据触发条件:

AbstractSource处理消息AbstractSource#executeMessageISink存储数据触发条件:

SinkAction算子触发流程(SinkAction):

IMessageCache#addCacheSinkAction#doMessageISink#openAutoFlushSinkAction#doProcessAfterRefreshConfigurableMessageCache#flush()ScheduleManager#startshared-nothing体现在RocketMQ的以下属性:

RocketMQ 消息的存储和查询原理

RocketMQ 如何发送一条消息

RocketMQ Streams在启动时会对上游的ISource拆分分片,AbstractPullSource#startSource

IPullSource#fetchAllSplitsISourceBalance#doBalanceAbstractPullSource#doSplitChanged容器的原理:Namespace做隔离,Cgroups做限制,rootfs做文件系统。

k8s的主要作用是调度容器,管理容器的生命周期,在k8s中调度的最小单位是pod,除此之外还有service、cluster这些概念。

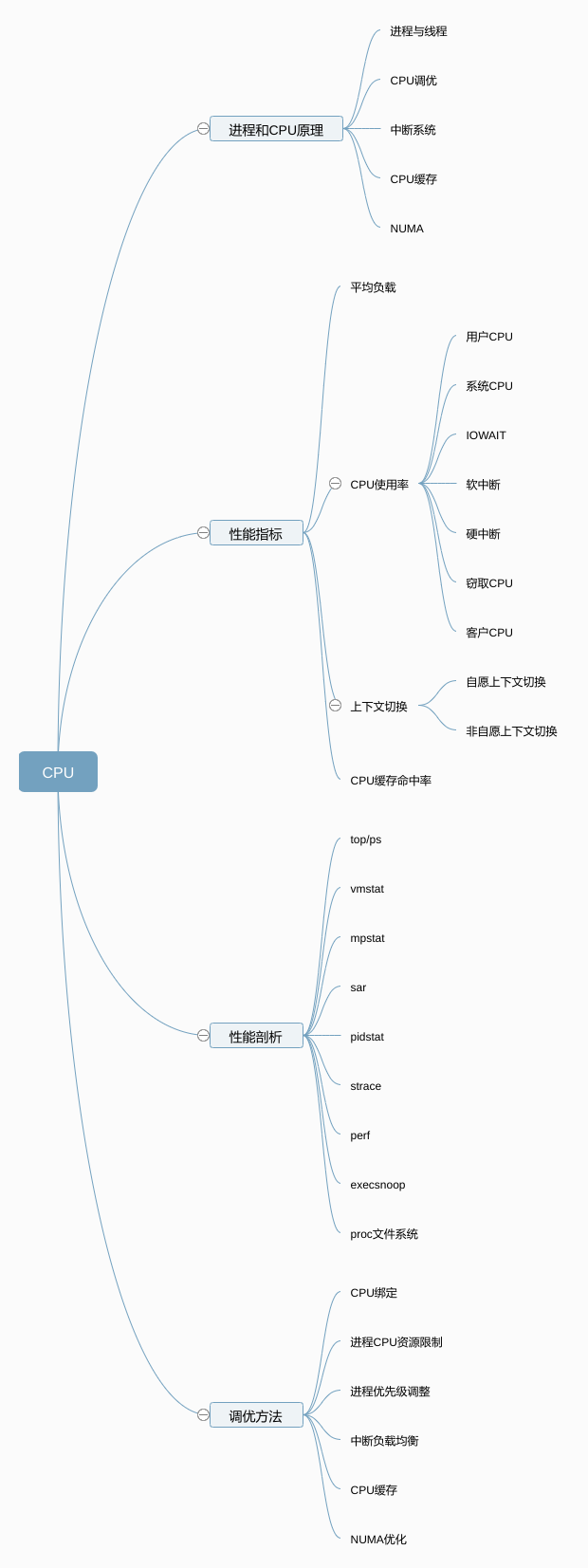

平均负载是指单位时间内,处于可运行状态和不可中断状态的平均进程数,也就是平均活跃进程数。所以,它不仅包括了正在使用 CPU 的进程,还包括等待 CPU 和等待 I/O 的进程,因此和CPU使用率也并没有直接关系。

当平均负载为2时,意味着:

平均负载为多少比较合适?

CPU 使用率,是单位时间内 CPU 繁忙情况的统计,跟平均负载并不一定完全对应。

比如:

CPU 密集型进程,使用大量 CPU 会导致平均负载升高,此时这两者是一致的;

I/O 密集型进程,等待 I/O 也会导致平均负载升高,但 CPU 使用率不一定很高;

大量等待 CPU 的进程调度也会导致平均负载升高,此时的 CPU 使用率也会比较高。

Linux 通过 /proc 虚拟文件系统,向用户空间提供了系统内部状态的信息,而 /proc/stat 提供的就是系统的 CPU 和任务统计信息:

1 | $ cat /proc/stat | grep ^cpu |

而CPU使用率,就是除了空闲时间外的其他时间占总CPU时间的百分比,用公式来表示就是:

1 | CPU使用率 = 1 - 空闲时间 / 总CPU时间 |

但是这个值是开机以来的CPU使用率,没什么参考价值,重要的是计算单位时间内的CPU使用率或简称平均CPU使用率。

1 | 平均CPU使用率 = 1 - (空闲时间new - 空闲时间old) / (总CPU时间new - 总CPU时间old) |

平均CPU使用率可以通过top、ps命令来查看。

造成CPU使用率过高的原因可能是:

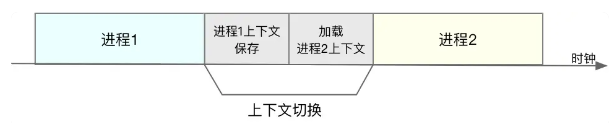

CPU 上下文切换,就是先把前一个任务的 CPU 上下文(也就是 CPU 寄存器和程序计数器)保存起来,然后加载新任务的上下文到这些寄存器和程序计数器,最后再跳转到程序计数器所指的新位置,运行新任务。

根据任务的不同,CPU 的上下文切换可以分为几个不同的场景,也就是进程上下文切换、线程上下文切换以及中断上下文切换。

根据Linux的特权等级分级:

系统调用过程的CPU上下文切换:

需要注意的是,系统调用过程中,并不会涉及到虚拟内存等进程用户态的资源,也不会切换进程。

进程上下文切换:

进程的上下文切换就比系统调用时多了一步:在保存当前进程的内核状态和 CPU 寄存器之前,需要先把该进程的虚拟内存、栈等保存下来;而加载了下一进程的内核态后,还需要刷新进程的虚拟内存和用户栈。

进程上下文潜在的性能问题:

切换进程上下文的时机:

只有在进程调度的时候,才需要切换上下文。Linux 为每个 CPU 都维护了一个就绪队列,将活跃进程(即正在运行和正在等待 CPU 的进程)按照优先级和等待 CPU 的时间排序,然后选择最需要 CPU 的进程,也就是优先级最高和等待 CPU 时间最长的进程来运行。

线程与进程最大的区别在于,线程是调度的基本单位,而进程则是资源拥有的基本单位。说白了,所谓内核中的任务调度,实际上的调度对象是线程;而进程只是给线程提供了虚拟内存、全局变量等资源。

当进程只有一个线程时,可以认为进程就等于线程。

当进程拥有多个线程时,这些线程会共享相同的虚拟内存和全局变量等资源。这些资源在上下文切换时是不需要修改的。

另外,线程也有自己的私有数据,比如栈和寄存器等,这些在上下文切换时也是需要保存的。

因此,根据切换的多个线程所属的进程不同,有2种情况:

同进程内的线程切换消耗的资源更少。

为了快速响应硬件的事件,中断处理会打断进程的正常调度和执行,转而调用中断处理程序,响应设备事件。而在打断其他进程时,就需要将进程当前的状态保存下来,这样在中断结束后,进程仍然可以从原来的状态恢复运行。

跟进程上下文不同,中断上下文切换并不涉及到进程的用户态。所以,即便中断过程打断了一个正处在用户态的进程,也不需要保存和恢复这个进程的虚拟内存、全局变量等用户态资源。中断上下文,其实只包括内核态中断服务程序执行所必需的状态,包括 CPU 寄存器、内核堆栈、硬件中断参数等。

1、平均负载

系统平均活跃进程数,反映了系统的整体负载情况

2、CPU使用率

根据CPU上运行任务的不同,CPU使用率可以分为:

3、进程上下文切换

过多的上下文切换会将原本运行进程的CPU时间,消耗在寄存器、内核栈以及虚拟内存等数据的保存和回复上,缩短进程真正运行的时间,成为性能瓶颈。包括:

4、CPU缓存的命中率

包括L1、L2、L3等三级缓存。

uptime - 查看平均负载

平均负载最理想情况下等于CPU个数,超过时表示发生了过载,达到70%时就应该分析排查负载高的问题,。

watch - 可用于观察负载变化情况

top 或 读取/proc/cpuinfo - 查看系统有几个CPU

top - 查看CPU使用率

-w 查看进程上下文切换情况

sysstat包含mpstat、pidstat

mpstat 是一个常用的多核 CPU 性能分析工具,用来实时查看每个 CPU 的性能指标,以及所有 CPU 的平均指标。

pidstat 是一个常用的进程性能分析工具,用来实时查看进程的 CPU、内存、I/O 以及上下文切换等性能指标。

主要用来分析系统的内存使用情况,也常用来分析CPU上下文切换和中断的次数

vmstat主要用于看系统整体的上下文切换情况,如果想看每个进程的详细情况,可以用pidstat

perf top 实时显示占用CPU时钟最多的函数或指令,因此可以用来查找热点函数

perf record、perf report 保存性能分析结果及展示结果

Future

刚开始接触并发编程,容易写出下面的代码:

1 | long startTime = System.currentTimeMillis(); |

此时开发很有可能会误以为结果是 1s 左右,毕竟 3 个FutureTask同时执行、每个只等待 1s,结果确实应该是 1s,但是这里并没有实现并行化,因为future.get是轮询调用的,第一个执行完毕后,第二个仍然需要等待 1s,因此结果是 3s。

虽然每个 FutureTask 是同时开始执行的,但是future.get并不是同时开始等待的,如果想要达到并行执行的效果,一定是在上一个执行完毕的时候,下一个就已经执行完毕了,此时就可以直接获取结果了。

1 | long startTime = System.currentTimeMillis(); |

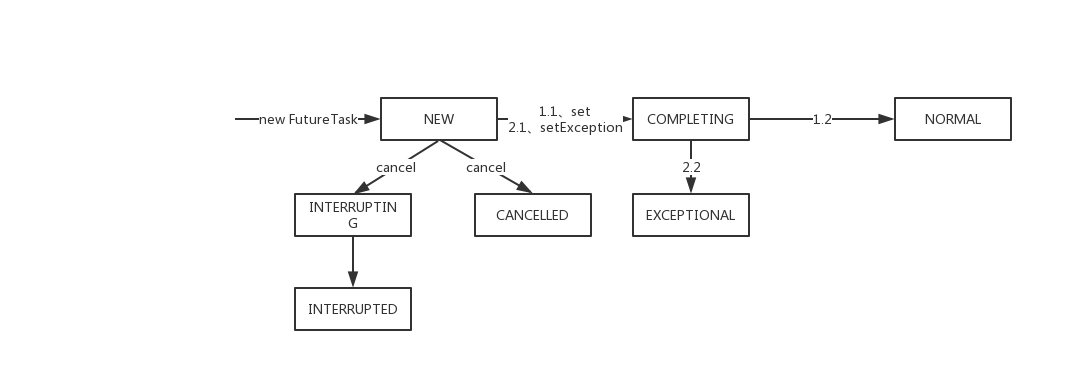

阻塞虽然看起来很廉价,似乎线程阻塞后就不占用资源了,实际上很多阻塞都是通过轮询标志位实现的,比如 FutureTask 内部实现了这样的一种状态机:

每次状态的变更都是通过CAS(UNSAFE)实现线程安全的,比如set方法:

1 | protected void set(V v) { |

ListenableFuture 是在 JDK1.8 之前出现的,现在 CompletableFuture 一般是更好的选择。

1 | long start = System.currentTimeMillis(); |

LinkedBlockingQueue;take调用一直不返回,注意下面源码中的done方法: 1 | private class QueueingFuture extends FutureTask<Void> { |

CompletableFuture是对Future的加强,CompletableFuture实现了 Future 接口,这意味着它本身也提供了通过阻塞或轮询获取结果的方式,相对 Future 来说,它的相对优势在于任务的编排,相对 CompletionService 来说,CompletableFuture又有接口更灵活的优势。

1 | long start = System.currentTimeMillis(); |

注意上面的CompletableFuture.supplyAsync和CompletableFuture.join

CompletableFuture.supplyAsync,有2个方法,其中有个需要用户指定Executor,如果没有指定则使用JDK内置的线程池ForkJoinPool.commonPool()AsyncSupply封装AsyncSupply.exec()CompletableFuture.internalCompleteCompletableFuture::joinCompletableFuture.waitingGetq = new WaitNode(interruptible, 0L, 0L);queued = UNSAFE.compareAndSwapObject(this, WAITERS, q.next = waiters, q);ForkJoinPool.managedBlock(q);阻塞,会调WaitNode.block()来判断是否还阻塞着CompletableFuture.internalComplete里的代码,会调LockSupport.unpark(t);唤醒等待的线程桐生枝梨子(高显秘书、相貌平平、认真、火灾毁容)

里中二郎(死者、高显亲生骨肉)

克子

一原高显(社长、癌症)

一原苍介(高显弟弟、大学教授)

一原直之(苍介弟弟、精明)

一原纪代美(苍介另一哥哥的太太)

由香(纪代美女儿)

一原曜子(苍介妹妹)

加奈江(曜子女儿)

本间重太郎(高显朋友)

本间菊代(重太郎太太、现假扮)

一原健彦(苍介儿子、喜欢由香)

小林真穗(店长、高显情人)

矢崎警部

古木律师

鲹泽弘美(古木助理)

尹之壹

火灾

车祸逃逸

高显遗嘱

七七法事

八泽温泉(墓地)

枝梨子遗书

由香的死:拿走信封、之后死了、倒着的N(俄语字母)、刀伤、勒脖

红酒

安眠药

审讯

直之的珍珠领带夹

私生子

脚印

纪代美的一对珍珠

头发

茶道

碎冰锥

在搜索的时候,我们能通过搜索关键词快速得到结果集。当排序的时候,我们需要倒排索引里面某个字段值的集合,此时倒排索引无法发挥作用。换句话说,我们需要 转置 倒排索引。转置 结构在其他系统中经常被称作 列存储 。实质上,它将所有单字段的值存储在单数据列中,这使得对其进行操作是十分高效的,例如排序。

ES有2种方法实现:

| Doc Values | Field data | |

|---|---|---|

| 何时创建 | 索引时,和倒排索引一起创建 | 搜索时动态创建 |

| 创建位置 | 磁盘文件 | JVM Heap |

| 优点 | 避免大量内存占用 | 索引速度快,不占用额外的磁盘空间 |

| 缺点 | 降低索引速度,占用额外磁盘空间 | 文档过多时,动态创建开销大,占用过多JVM Heap |

| 缺省值 | ES 2.x 之后 | ES 1.x 及之前 |

当 working set 远小于节点的可用内存,系统会自动将所有的文档值保存在内存中,使得其读写十分高速; 当其远大于可用内存,操作系统会自动把 Doc Values 加载到系统的页缓存中,从而避免了 jvm 堆内存溢出异常。

Doc Value默认是启用的,可以通过Mapping设置关闭

1 | PUT test_keyword/_mapping |

1 | "tweet": { |

1 | GET /_search?explain |

几种分页方式及应用场景

ES中的分页是从每个分片上获取from + size条数据,然后协调节点聚合所有结果,再选取前from + size条数据。

因为是from + size,所以from特别大时会有深分页问题。

解决办法是Search After:

1 | POST users/_search |

缺点是:

需要指定搜索sort:

Search After会通过唯一排序值定位,将每次要处理的文档数都控制在size个。

scroll 查询 可以用来对 Elasticsearch 有效地执行大批量的文档查询,而又不用付出深度分页那种代价。

游标查询允许我们 先做查询初始化,然后再批量地拉取结果。 这有点儿像传统数据库中的 cursor 。

游标查询会取某个时间点的快照数据。 查询初始化之后索引上的任何变化会被它忽略。 它通过保存旧的数据文件来实现这个特性,结果就像保留初始化时的索引 视图 一样。

深度分页的代价根源是结果集全局排序,如果去掉全局排序的特性的话查询结果的成本就会很低。 游标查询用字段 _doc 来排序。 这个指令让 Elasticsearch 仅仅从还有结果的分片返回下一批结果。

启用游标查询可以通过在查询的时候设置参数 scroll 的值为我们期望的游标查询的过期时间。 游标查询的过期时间会在每次做查询的时候刷新,所以这个时间只需要足够处理当前批的结果就可以了,而不是处理查询结果的所有文档的所需时间。 这个过期时间的参数很重要,因为保持这个游标查询窗口需要消耗资源,所以我们期望如果不再需要维护这种资源就该早点儿释放掉。 设置这个超时能够让 Elasticsearch 在稍后空闲的时候自动释放这部分资源。

1 | GET /old_index/_search?scroll=1m // 保持游标查询窗口一分钟。 |

这个查询的返回结果包括一个字段 _scroll_id, 它是一个 base64 编码的长字符串。现在我们能传递字段 _scroll_id 到 _search/scroll 查询接口获取下一批结果:

1 | GET /_search/scroll |

这个游标查询返回的下一批结果。 尽管我们指定字段 size 的值为 1000,我们有可能取到超过这个值数量的文档。 当查询的时候, 字段 size 作用于单个分片,所以每个批次实际返回的文档数量最大为 size * number_of_primary_shards。

当没有更多结果返回的时候,我们就处理完所有匹配的文档了。

缺点:

ES提供了几种默认的计算分值的函数:

设置权重

使用某个数值修改_score的值,比如乘以某个系数

原算分乘以某个字段得到最终结果,比如下面就是乘以原文档中的count字段

1 | GET doc/_search |

还可以根据某个函数来计算评分,比如如下命令新算分 = 老算分 * log(1 + factor * count):

1 | GET doc/_search |

为每一个用户使用一个不同的,随机算分结果

使用场景:让每个用户能看到不同的随机排名,但是也希望同一个用户访问时,结果的相对顺序保持一致

1 | GET doc/_search |

以某个字段的值为标准,距离某个值越近,得分越高

自定义脚本完全控制所需逻辑

elasticsearch painless脚本评分

Elasticsearch中使用painless实现评分

1 | GET doc/_search |

计算目标文档和origin之间的距离

衰减函数